セミナーレポート

ロボットが目で見たものを掴むまで 3次元ビジョンセンサー,認識アルゴリズム,認識と動作のキャリブレーションを組み合わせる三菱電機(株) 堂前 幸康

本記事は、画像センシング展2013にて開催された特別招待講演を記事化したものになります。

3次元ビジョンセンサーで見て,認識アルゴリズムで掴み方を考える

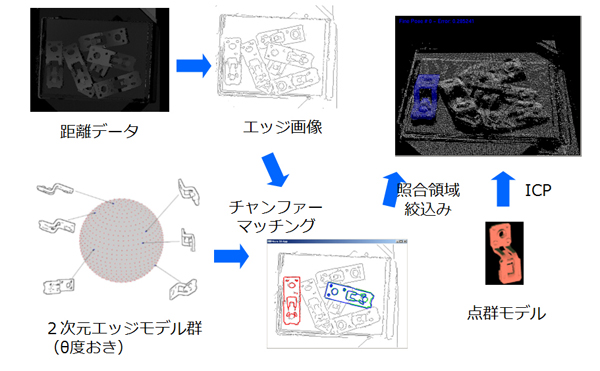

3次元ビジョンセンサーは対象物体の色(輝度)だけでなく,3次元(奥行き)情報=距離を測ります。3次元センサーは多くの企業から多数の製品が発売されており,得手不得手があります。その中で,距離分解能がサブミクロンオーダーの産業用途の精密計測向け製品は1000万円ほどで比較的高価です。計測方式で多く使われているのが三角測量をベースにしたパターン投光方式で,プロジェクターからドットパターンを投光して計測します。もう1つ,縦スリットをたくさん当てる空間コード化法というやり方がありますが,精度は高いのですが,パターン枚数分,時間がかかります。三菱電機のボストン研究所では,両方の良い部分を融合させた方法を発表しました。そして,開発を進めた結果,3次元ビジョンセンサー「MELFA 3D-VISION」では,生産システムがターゲットとするバラ積みの電気・電子部品を必要な時間と精度で測ることができました。次が掴み方を考える認識アルゴリズムです。距離データからの物体の掴み方について,真っ先に浮かぶのは,物体の位置姿勢を認識することです。そのためには,距離データと物体の照合が必要で,例えば物体形状を点の集合で表した点群モデル,もしくは物体形状をエッジの集合で表したエッジモデルを事前に持っておきます。点群モデルの照合は高精度ですが,処理が重く,局所解に陥りやすく,エッジモデルの照合は,処理は軽く,局所解に陥りにくいのですが,高精度化するとモデル数が増えます。

図2 物体の位置姿勢認識処理フロー

<次ページへ続く>

三菱電機(株) 堂前 幸康

- 2004年

- 北海道大学工学部システム工学科卒業

- 2006年

- 北海道大学大学院情報科学研究科システム情報科学専攻修了

- 2008年

- 北海道大学大学院情報科学研究科システム情報科学専攻博士後期課程単位取得退学

- 2008年

- 三菱電機株式会社入社、先端技術総合研究所勤務

- 2012年

- 北海道大学情報科学博士